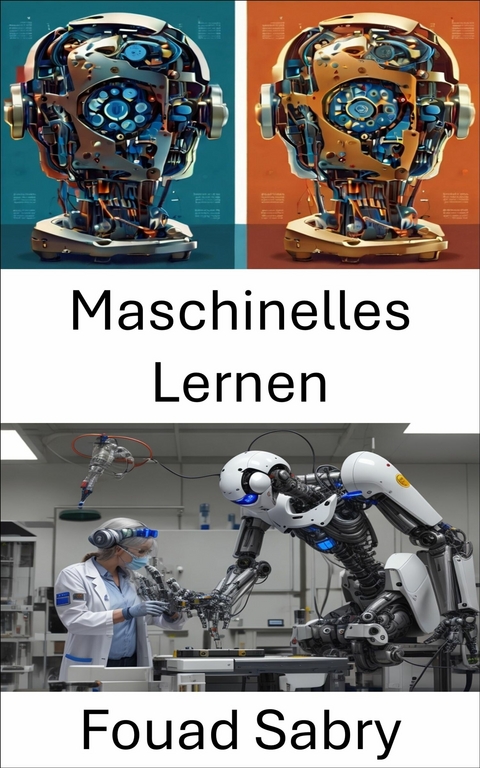

Maschinelles Lernen (eBook)

317 Seiten

Eine Milliarde Sachkundig [German] (Verlag)

978-0-00-069317-4 (ISBN)

Entdecken Sie in diesem umfassenden Leitfaden die Welt des maschinellen Lernens und seine Schnittstelle zur Robotikwissenschaft. Dieses Buch führt die Leser in die grundlegenden Konzepte des maschinellen Lernens ein und zeigt dessen entscheidende Rolle in der modernen Robotik. Es ist ideal für Profis, Studenten und Enthusiasten und bietet einen umfassenden Einblick in die Fortschritte, praktischen Anwendungen und Zukunftspotenziale des Bereichs. Damit ist es eine wertvolle Ressource für alle, die sich mit Robotik und maschinellem Lernen beschäftigen.

Kurzübersicht der Kapitel:

1: Maschinelles Lernen Ein Überblick über die Prinzipien des maschinellen Lernens in der Robotik.

2: Künstliche Intelligenz Untersucht die integrale Rolle der KI bei der Verbesserung der Fähigkeiten von Robotern.

3: Überwachtes Lernen Befasst sich mit Modellen, bei denen Ergebnisse die Entscheidungen von Robotern leiten.

4: Neuronales Netzwerk (Maschinelles Lernen) Stellt neuronale Netzwerkarchitekturen für Roboter vor.

5: Mustererkennung Behandelt die Rolle von Mustern bei der Wahrnehmung und Entscheidungsfindung von Robotern.

6: Unüberwachtes Lernen Untersucht datengesteuerte Erkenntnisse für autonome Roboterfunktionen.

7: Trainings-, Validierungs- und Testdatensätze Untersucht die Datenaufbereitung für Roboteranwendungen.

8: MetaLearning (Informatik) Bespricht das Lernen von Robotern, um ihr eigenes Lernen zu optimieren.

9: Hierarchisches Zeitgedächtnis Untersucht fortgeschrittene Gedächtnismodelle für die Robotik.

10: Datenanalyse zur Betrugserkennung Veranschaulicht maschinelles Lernen in der Robotersicherheit.

11: Arten künstlicher neuronaler Netzwerke Überblick über in der Robotik angewandte neuronale Netzwerke.

12: Deep Learning Untersucht komplexe, mehrschichtige Netzwerke für fortgeschrittene Robotik.

13: Lernregel Bespricht die auf Roboterintelligenz angewandten Lernprinzipien.

14: Feature Learning Beschreibt das Extrahieren bedeutungsvoller Muster in Robotikkontexten.

15: Deep Belief Network Bespricht tiefe Glaubensstrukturen für das Roboterlernen.

16: Domänenanpassung Behandelt die Anpassung von Robotern an neue Umgebungen und Aufgaben.

17: Inkrementelles Lernen Zeigt die Fähigkeit von Robotern, auf vorherigem Lernen aufzubauen.

18: Erklärbare künstliche Intelligenz Konzentriert sich auf Transparenz bei Roboterentscheidungen.

19: Selbstüberwachtes Lernen Untersucht selbständige Lernmethoden in der Robotik.

20: Symbolische künstliche Intelligenz Erforscht logikbasierte KI für die Robotik.

21: Neats and Scruffies Analysiert die strukturierten und flexiblen Ansätze in der Robotik.

Dieses Buch ist nicht nur ein technischer Leitfaden, sondern eine aufschlussreiche Reise durch die Robotikwissenschaft. Da maschinelles Lernen die Branche weiterhin verändert, bietet dieses Werk sowohl praktische Werkzeuge als auch theoretische Erkenntnisse, sodass die Investition in dieses Wissen eine kluge Wahl für zukünftige Innovatoren ist.

Kapitel 2 : Künstliche Intelligenz

Im Gegensatz zur natürlichen Intelligenz von Tieren, einschließlich des Menschen, bezieht sich Künstliche Intelligenz (KI) auf die Intelligenz, die Roboter demonstrieren. Die Forschung im Bereich der künstlichen Intelligenz (KI) wurde als das Forschungsgebiet der intelligenten Agenten beschrieben, das sich auf jedes System bezieht, das seine Umgebung wahrnimmt und Aktionen ausführt, die seine Möglichkeiten zur Erreichung seiner Ziele optimieren. Mit anderen Worten: Die KI-Forschung ist eine Disziplin, die sich mit intelligenten Agenten beschäftigt. Der Begriff "KI-Auswirkungen" bezieht sich auf den Prozess, bei dem Aktivitäten, von denen früher angenommen wurde, dass sie "Intelligenz" benötigen, aber mit fortschreitender Technologie nicht mehr in das Konzept der künstlichen Intelligenz einbezogen werden. KI-Forscher haben eine Vielzahl von Ansätzen zur Lösung von Problemen angepasst und integriert, darunter Suche und mathematische Optimierung, formale Logik, künstliche neuronale Netze und Methoden, die auf Statistik, Wahrscheinlichkeit und Wirtschaft basieren, um diese Schwierigkeiten zu bewältigen. Informatik, Psychologie, Linguistik, Philosophie und viele andere akademische Disziplinen tragen zur Entwicklung der KI bei.

Die Theorie, dass der menschliche Intellekt "so genau charakterisiert werden kann, dass ein Computer so konstruiert werden kann, dass er ihn nachahmt", war das Leitprinzip hinter der Etablierung dieser Disziplin. Dies löste philosophische Debatten über den Verstand und die ethischen Implikationen aus, die es mit sich bringt, künstliche Organismen mit einem Intellekt auszustatten, der mit dem des Menschen vergleichbar ist; Dies sind Themen, die seit der Antike von Mythen, Literatur und Philosophie untersucht werden.

In der Antike wurden künstliche Kreaturen mit künstlicher Intelligenz in verschiedenen narrativen Mitteln eingesetzt.

und sind häufig in literarischen Werken zu sehen, wie in Mary Shelleys Frankenstein oder Karel Čapeks R.U.R.

Das formale Design für Turing-vollständige "künstliche Neuronen", das McCullouch und Pitts 1943 entwickelten, war die erste Arbeit, die heute weithin als Beispiel für künstliche Intelligenz verstanden wird.

Die Teilnehmer der Konferenz wurden zu Pionieren auf dem Gebiet der KI-Forschung.

Sie waren in der Lage, zusammen mit ihren Schülern Programme zu entwickeln, die von der Presse als "erstaunlich" bezeichnet wurden. Zu diesen Programmen gehörten Maschinen, die in der Lage waren, Dametechniken zu erlernen, Textaufgaben in Algebra zu lösen, logische Theoreme zu demonstrieren und die englische Sprache gut zu beherrschen.

Um die Mitte des Jahrzehnts der 1960er Jahre wurden in den Vereinigten Staaten

erhielt eine beträchtliche Summe an Finanzmitteln vom Verteidigungsministerium, und Einrichtungen wurden auf der ganzen Welt eingerichtet.

sowie des anhaltenden Drucks des Kongresses der Vereinigten Staaten, in fruchtbarere Unternehmungen zu investieren, Die Vereinigten Staaten von Amerika

Sowohl die kanadische als auch die britische Regierung haben die Finanzierung der explorativen Forschung im Bereich der künstlichen Intelligenz eingestellt.

Die folgenden Jahre sollten in Zukunft als "KI-Winter" bezeichnet werden.

Eine Zeit, in der es schwierig war, Finanzmittel für Initiativen der künstlichen Intelligenz zu erhalten.

Eine Art Software mit künstlicher Intelligenz, die das Wissen und die analytischen Fähigkeiten menschlicher Fachleute nachahmt.

1985 wurden bereits über eine Milliarde Dollar im Geschäft mit künstlicher Intelligenz umgesetzt.

Währenddessen haben die Vereinigten Staaten und das Vereinigte Königreich die Unterstützung für die universitäre Forschung als unmittelbare Folge des japanischen Computerprogramms für die fünfte Generation wieder aufgenommen.

Als jedoch 1987 der Markt für Lisp-Maschinen zusammenbrach, war dies der Beginn einer Abwärtsspirale.

Die KI fiel erneut in Ungnade, und ein weiterer, länger anhaltender Winter begann.

Geoffrey Hinton wird zugeschrieben, das Interesse an neuronalen Netzen und dem Konzept des "Konnektionismus" wiederbelebt zu haben.

Um die Mitte der 1980er Jahre waren David Rumelhart und einige andere daran beteiligt. In den 1980er Jahren wurden viele Soft-Computing-Tools entwickelt.

Dazu gehören Dinge wie neuronale Netze, Fuzzy-Systeme, die Theorie des grauen Systems, der Einsatz von evolutionärem Rechnen sowie eine Reihe von Methoden, die aus der statistischen oder mathematischen Optimierung abgeleitet sind.

In den späten 1990er Jahren und bis in das frühe 21. Jahrhundert hinein arbeitete die KI daran, ihr Image schrittweise zu rehabilitieren, indem sie Lösungen entwickelte, die auf bestimmte Herausforderungen zugeschnitten waren. Aufgrund der engen Fokussierung konnten die Forscher Schlussfolgerungen entwickeln, die überprüft werden konnten, eine größere Anzahl mathematischer Ansätze verwenden und mit Experten aus anderen Bereichen (wie Statistik, Wirtschaft und Mathematik) zusammenarbeiten. In den 1990er Jahren wurden die Lösungen, die von KI-Forschern entwickelt wurden, nie als "künstliche Intelligenz" bezeichnet, aber im Jahr 2000 wurden sie weltweit in großem Umfang eingesetzt. Laut Jack Clark von Bloomberg war das Jahr 2015 ein Wendejahr für künstliche Intelligenz. Dies ist auf die Tatsache zurückzuführen, dass die Anzahl der Softwareprojekte, die KI bei Google einsetzen, von "sporadischer Nutzung" im Jahr 2012 auf mehr als 2.700 Projekte im Jahr 2015 gestiegen ist.

Die übergeordnete Herausforderung, Intelligenz zu emulieren (oder zu fabrizieren), wurde in eine Vielzahl spezifischerer Herausforderungen unterteilt. Dies sind bestimmte Eigenschaften oder Fähigkeiten, die Forscher von einem intelligenten System erwarten. Das größte Gewicht wurde auf die Eigenschaften gelegt, die im Folgenden beschrieben werden.

In den Anfängen der Informatik entwickelten Forscher Algorithmen, die das Schritt-für-Schritt-Denken widerspiegelten, das Menschen verwenden, wenn sie Probleme lösen oder logische Schlussfolgerungen ziehen. Die Forschung im Bereich der künstlichen Intelligenz hatte in den späten 1980er und frühen 1990er Jahren Strategien für den Umgang mit unsicheren oder unvollständigen Informationen entwickelt. Diese Ansätze bedienten sich an Begriffen aus der Wahrscheinlichkeit und der Ökonomie. Selbst beim Menschen ist die Art von Schritt-für-Schritt-Schlussfolgerung, die frühe Studien zur künstlichen Intelligenz replizieren konnten, unüblich. Sie sind in der Lage, die meisten ihrer Probleme anzugehen, indem sie schnelle Entscheidungen treffen, die auf ihrer Intuition basieren.

Information Engineering und die Repräsentation dieses Wissens ermöglichen es Systemen der künstlichen Intelligenz, intelligent auf Anfragen zu reagieren und Rückschlüsse auf reale Ereignisse zu ziehen.

Eine Ontologie ist eine Sammlung von Objekten, Beziehungen, Ideen und Attributen, die formal charakterisiert werden, um sicherzustellen, dass Softwareagenten in der Lage sind, sie zu verstehen. Eine Ontologie ist eine Beschreibung dessen, "was existiert". Obere Ontologien sind Ontologien, die versuchen, eine Grundlage für alle anderen Informationen zu bieten und als Vermittler zwischen Domänenontologien fungieren, die spezialisiertes Wissen über eine bestimmte Wissensdomäne abdecken. Obere Ontologien sind die am weitesten gefassten Ontologien und werden auch als Ontologien (Field of Interest oder Area of Concern) bezeichnet. Eine Software, die wirklich intelligent ist, würde auch Zugang zu gesundem Menschenverstand benötigen, d. h. zu einer Sammlung von Fakten, die dem typischen Menschen bekannt sind. In den meisten Fällen wird die Beschreibungslogik einer Ontologie, wie z. B. die Web Ontology Language, verwendet, um die Semantik einer Ontologie auszudrücken. Zusätzlich zu anderen Bereichen, Situationen, Ereignissen, Zuständen und Zeiten; Ursachen und Wirkungen; Wissen über Wissen (was wir über das wissen, was andere Menschen wissen); Standardargumentation (Dinge, von denen Menschen annehmen, dass sie wahr sind, bis sie eines Besseren belehrt werden, und die auch dann noch wahr sein werden, wenn sich andere Fakten ändern); und Wissen über Wissen über Wissen sind Beispiele für Domänen. Die Breite der Informationen über den gesunden Menschenverstand (die Anzahl der atomaren Fakten, die dem typischen Menschen bekannt sind, ist immens) und die subsymbolische Natur des Großteils des Wissens des gesunden Menschenverstandes sind zwei der größten Herausforderungen in der künstlichen Intelligenz (vieles von dem, was die Menschen wissen, wird nicht als "Fakten" oder "Aussagen" dargestellt, die sie verbal ausdrücken könnten). Bildinterpretation, therapeutische Entscheidungsunterstützung, Wissensentdeckung (die Extraktion von "interessanten" und umsetzbaren Erkenntnissen aus großen Datensätzen) und andere Disziplinen sind alles Bereiche, die von künstlicher Intelligenz profitieren könnten.

Ein intelligenter Agent, der in der Lage ist zu planen, erstellt eine Repräsentation des aktuellen Zustands der Welt, macht Vorhersagen darüber, wie sich seine Handlungen auf die Umwelt auswirken werden, und trifft Entscheidungen, die den Nutzen (oder "Wert") der verfügbaren Optionen maximieren. Bei traditionellen Planungsproblemen kann der Agent davon ausgehen, dass es das einzige funktionierende System auf der Welt ist. Auf diese Weise kann sich der Agent auf die Ergebnisse verlassen, die sich aus den von ihm ergriffenen Maßnahmen ergeben. Wenn der Agent jedoch nicht der einzige Akteur ist, ist es notwendig, dass der Agent unter Unklarheiten argumentiert, seine Umgebung ständig neu bewertet und...

| Erscheint lt. Verlag | 1.1.2025 |

|---|---|

| Übersetzer | Daniel Hueber |

| Sprache | deutsch |

| Themenwelt | Technik ► Maschinenbau |

| ISBN-10 | 0-00-069317-0 / 0000693170 |

| ISBN-13 | 978-0-00-069317-4 / 9780000693174 |

| Informationen gemäß Produktsicherheitsverordnung (GPSR) | |

| Haben Sie eine Frage zum Produkt? |

Größe: 1,1 MB

Kopierschutz: Adobe-DRM

Adobe-DRM ist ein Kopierschutz, der das eBook vor Mißbrauch schützen soll. Dabei wird das eBook bereits beim Download auf Ihre persönliche Adobe-ID autorisiert. Lesen können Sie das eBook dann nur auf den Geräten, welche ebenfalls auf Ihre Adobe-ID registriert sind.

Details zum Adobe-DRM

Dateiformat: EPUB (Electronic Publication)

EPUB ist ein offener Standard für eBooks und eignet sich besonders zur Darstellung von Belletristik und Sachbüchern. Der Fließtext wird dynamisch an die Display- und Schriftgröße angepasst. Auch für mobile Lesegeräte ist EPUB daher gut geeignet.

Systemvoraussetzungen:

PC/Mac: Mit einem PC oder Mac können Sie dieses eBook lesen. Sie benötigen eine

eReader: Dieses eBook kann mit (fast) allen eBook-Readern gelesen werden. Mit dem amazon-Kindle ist es aber nicht kompatibel.

Smartphone/Tablet: Egal ob Apple oder Android, dieses eBook können Sie lesen. Sie benötigen eine

Geräteliste und zusätzliche Hinweise

Buying eBooks from abroad

For tax law reasons we can sell eBooks just within Germany and Switzerland. Regrettably we cannot fulfill eBook-orders from other countries.

aus dem Bereich